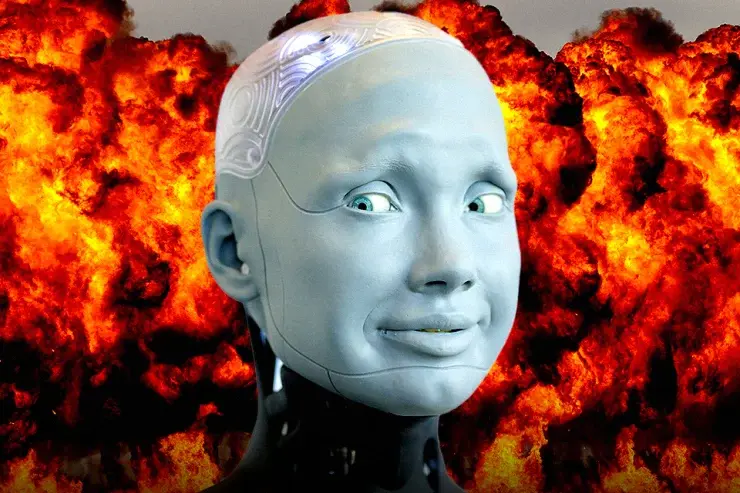

Лошадь ИИ убежала. Пришло время для ядерного варианта

Эксперт по биобезопасности из Массачусетского технологического института недавно предложил своим студентам использовать общедоступные инструменты генеративного искусственного интеллекта (ИИ) для выявления вируса, способного вызвать пандемию. Студентам потребовался всего час, чтобы составить список из четырех вирусов-кандидатов.

В отличие от потенциального вклада ИИ в жизнь общества, почти ежедневно публикуются новые опасения по поводу его возможности использования для разработки мощных химических токсинов, замены действующих лиц их подобиями без их согласия, совершения незаметных мошенничеств, распространения дезинформации во время выборов и создания автономных оружие.

Призывы к регулированию раздаются почти ежедневно. Европейский парламент одобрил широкомасштабные законопроекты, которые, если они будут приняты, ограничат использование ИИ и предоставят роль человеческого надзора, качества данных и подотчетности. Европейские компании возражают, опасаясь, что предлагаемый закон не будет эффективным в борьбе с рисками ИИ и нанесет ущерб конкурентоспособности европейского бизнеса.

Беда регуляторов в том, что лошадь убежала. ИИ везде. Регламенты будут соблюдаться организациями с высокой степенью добросовестности, и они должным образом будут маркировать свою продукцию. Однако правила неизбежно будут проигнорированы преступными организациями, террористическими группами и государствами-изгоями.

Чтобы добавить к дилемме, если некоторые страны должны были затормозить развитие, другие с историей поддержки терроризма и разработки ядерного оружия проигнорировали бы призыв и вырвались вперед в гонке ИИ.

Поскольку регулировать ИИ сложно, должны ли мы ничего не делать? Нет. Риск настолько велик, что прятать наши коллективные головы в песок — это не выход. Призывы технологических лидеров к перерыву в разработке ИИ не являются ответом. Правила, которые затрагивают только благонамеренных, добросовестных разработчиков и пользователей ИИ, не являются ответом.

Возможно, ответ придет из нестандартного мышления. Чему нас учит договор о нераспространении ядерного оружия, вступивший в силу в 1970 году?

Хотя это и не идеально, оно замедлило распространение ядерного оружия, и сегодня арсеналы составляют примерно одну пятую от того, что было 50 лет назад. Соглашение стало возможным благодаря тому, что стоимость и масштабы разработки ядерного оружия настолько велики, что регулируемые объекты, такие как шахты, реакторы и установки по обогащению, могут контролироваться международными аудиторскими группами и с помощью спутникового наблюдения для проверки соблюдения. Проблема не решена, но мы наслаждались десятилетиями передышки.

Эквивалентными объектами регулирования в мире технологий ИИ являются предприятия, производящие микрочипы, необходимые для работы алгоритмов ИИ. Это хорошо осознает правительство США, которое ввело карательные ограничения на экспорт в Китай не только передовых микрочипов, но и производственного оборудования для их изготовления.

Хотя хорошо известно, что размеры и стоимость транзисторов в микрочипе уменьшались на протяжении десятилетий, менее известно, что размеры и стоимость заводов по производству все более мощных микрочипов неуклонно росли, а стоимость строительство современного завода по производству оценивается как минимум в 3 миллиарда долларов США и до 20 миллиардов долларов США. Эти массивные и сложные заводы огромны и могут быть легко проверены международными аудиторскими группами.

Чтобы быть успешным, договор о нераспространении ИИ должен быть согласован каждой технологически развитой страной или юрисдикцией, включая США, Китай, Европу, Тайвань и многие другие, несмотря на определенные возражения оборонных сообществ в каждой стране. Исключения допускать нельзя, ибо неучастие в технологической гонке вооружений было бы огромным преимуществом.

Одной из наиболее важных деталей договора будет соглашение об уровне возможностей, который не должен превышаться. Определение должно быть ошеломляюще простым, чтобы его нельзя было интерпретировать двусмысленно. Например, уровень возможностей может быть определен как максимальное количество транзисторов на микрочип. Могут быть согласованы такие ограничения, как не более 100 миллиардов.

Конечно, нам нужны компьютерные микрочипы для наших смартфонов, банковских систем и систем спутниковой навигации. Но нужны ли нам необычайно мощные микрочипы, обеспечивающие работу генеративного ИИ? Что определяет грань между адекватной силой и предельной силой? От чего бы мы отказались в обмен на защиту от злонамеренного использования ИИ?

Как и усилия по борьбе с изменением климата, переговоры по международному соглашению о нераспространении ядерного оружия потребуют исключительно масштабного сотрудничества. Учитывая взрывную скорость развития ИИ, мировое сообщество не может позволить себе медлить. Чтобы согласованные на международном уровне подходы были эффективными до того, как цунами ИИ снова удвоится или учетверится, цель будет состоять в том, чтобы договориться о соглашении в течение года или двух. В знак признания новизны подхода соглашение инициирует пересмотр своих собственных условий через каждые пять лет или около того.

Кто проявит лидерство в переговорах по договору о нераспространении ИИ? Это коллективная ответственность, и Австралия, безусловно, могла бы внести свой вклад.

Алан Финкель — австралийский нейробиолог, изобретатель, исследователь, предприниматель, педагог, политический советник и филантроп. Он был главным ученым Австралии с 2016 по 2020 год.