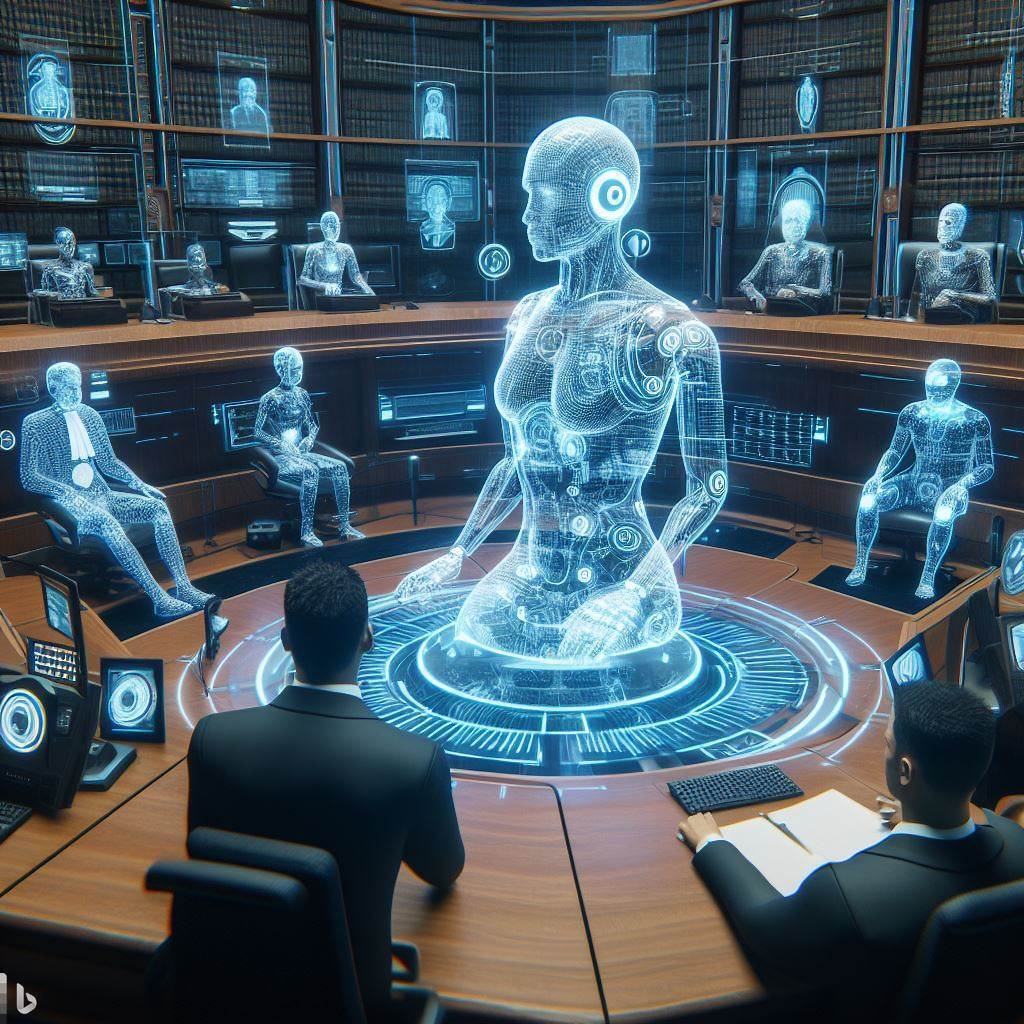

Этические проблемы применения нейросетей в юриспруденции

Искусственный интеллект активно проникает в сферу юриспруденции. Алгоритмы машинного обучения помогают в анализе правовых документов, предсказании судебных решений, оценке юридических рисков. Однако внедрение ИИ сопряжено с рядом этических вопросов.

Одна из главных проблем – обеспечение прозрачности работы алгоритмов.

Как правило, нейросети представляют собой «черные ящики», принцип работы которых непонятен человеку. Это противоречит принципу верховенства права и открытости правосудия.

Еще одна дилемма – ответственность за решения ИИ.

Могут ли алгоритмы заменить человеческое усмотрение? Кто будет нести ответственность за ошибки? Эти вопросы пока не имеют однозначного ответа.

Кроме того, существуют опасения относительно предвзятости алгоритмов. Нейросети обучаются на данных, которые могут содержать скрытые стереотипы и предрассудки. Это ведёт к риску автоматизации дискриминации.

Для этичного внедрения ИИ в юридическую практику нужны прозрачные алгоритмы, чёткие правила ответственности и минимизация предвзятости путём контроля качества данных. Только так технологии смогут по-настоящему способствовать справедливому правосудию.