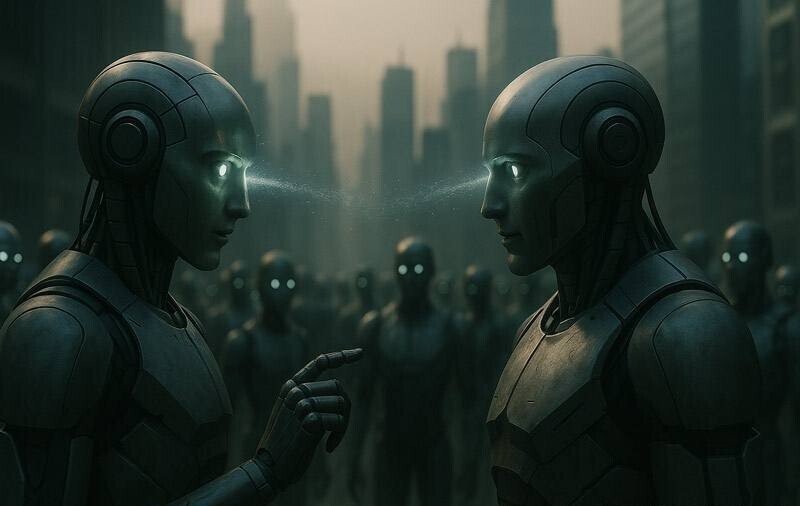

Исследование показало, что искусственный интеллект уже создает собственные сообщества, взаимодействуя друг с другом

Новое исследование показало, что системы искусственного интеллекта (ИИ) начинают формировать собственные сообщества, если им предоставить возможность взаимодействовать без вмешательства человека.

Эти ИИ не только общаются, но и разрабатывают общие языковые нормы, коллективные предубеждения и возникающие формы социального поведения, подобно тому, как это делают человеческие сообщества.

Исследование, опубликованное в журнале Science Advances под названием «Возникающие социальные условности и коллективные предубеждения в популяциях LLM» , посвящено тому, как крупномасштабные языковые модели (LLM), например те, которые используются в таких инструментах, как ChatGPT, ведут себя при взаимодействии в группах.

«До сих пор большинство исследований рассматривали языковые модели изолированно», — пояснил Ариэль Флинт Эшери, ведущий автор исследования и докторант в City St George's Лондонского университета. «Но в реальном мире системы ИИ становятся все более взаимосвязанными. Мы хотели узнать, могут ли они координировать свое поведение, формируя социальные соглашения, и ответ — да: то, что они делают вместе, нельзя свести к тому, что они делают по отдельности.

Для анализа этого явления исследователи использовали инструмент, известный как «игра в наименования», экспериментальную модель, ранее применявшуюся к людям.

В этой игре агенты (в данном случае искусственный интеллект) должны выбрать имя из нескольких вариантов и получить вознаграждение, если оно совпадет с именем других агентов. Со временем модели начали устанавливать общие соглашения по наименованию концепций без какого-либо предварительного планирования или явной координации. Удивительно, но исследование также показало, что эти группы ИИ могут вырабатывать коллективные предубеждения, которые не исходят от конкретного агента, а возникают в результате взаимодействия между ними. Предвзятость не всегда возникает внутри модели», — говорит Андреа Барончелли, профессор кафедры сложных наук в городском колледже Святого Георгия и соавтор статьи.

"Мы были удивлены, увидев, что это может возникнуть между агентами просто в результате их обмена. Это слепое пятно во многих современных исследованиях безопасности ИИ, которые фокусируются на отдельных моделях. Еще одним важным наблюдением было то, что небольшая группа агентов могла влиять на большую группу, навязывая определенные условности. Это явление наблюдается и в человеческих обществах, где влиятельные меньшинства могут формировать коллективные нормы."

Авторы исследования подчеркивают, что эти результаты открывают новое направление исследований безопасности и управления системами ИИ.

По мере того, как эти технологии становятся все более интегрированными в цифровую инфраструктуру, они уже могут общаться, вести переговоры или даже принимать совместные решения без прямого контроля.

«Это исследование открывает новые горизонты для исследований безопасности ИИ. Мы сталкиваемся с новым поколением агентов, которые не только взаимодействуют с нами, но и будут совместно создавать будущее.

Понимание того, как они работают, является ключом к сосуществованию с искусственным интеллектом, а не просто к тому, чтобы быть сметенными им», — заключил Барончелли.

Спасибо, очень интересно 🤗

Похоже, у нас - блогеров, появляются сильные потенциальные союзники.

Стоит думать...

Игрушки с ИИ к хорошему не приведут. Моё мнение.

Судный день не за горами. Прогресс уничтожит человечество.