Сможем ли мы когда-нибудь доверять медицинским рекомендациям искусственного интеллекта?

Медицинские чат-боты с искусственным интеллектом обладают потенциалом для консультирования пациентов, однако неверные ответы и предвзятое отношение остаются серьезными рисками.

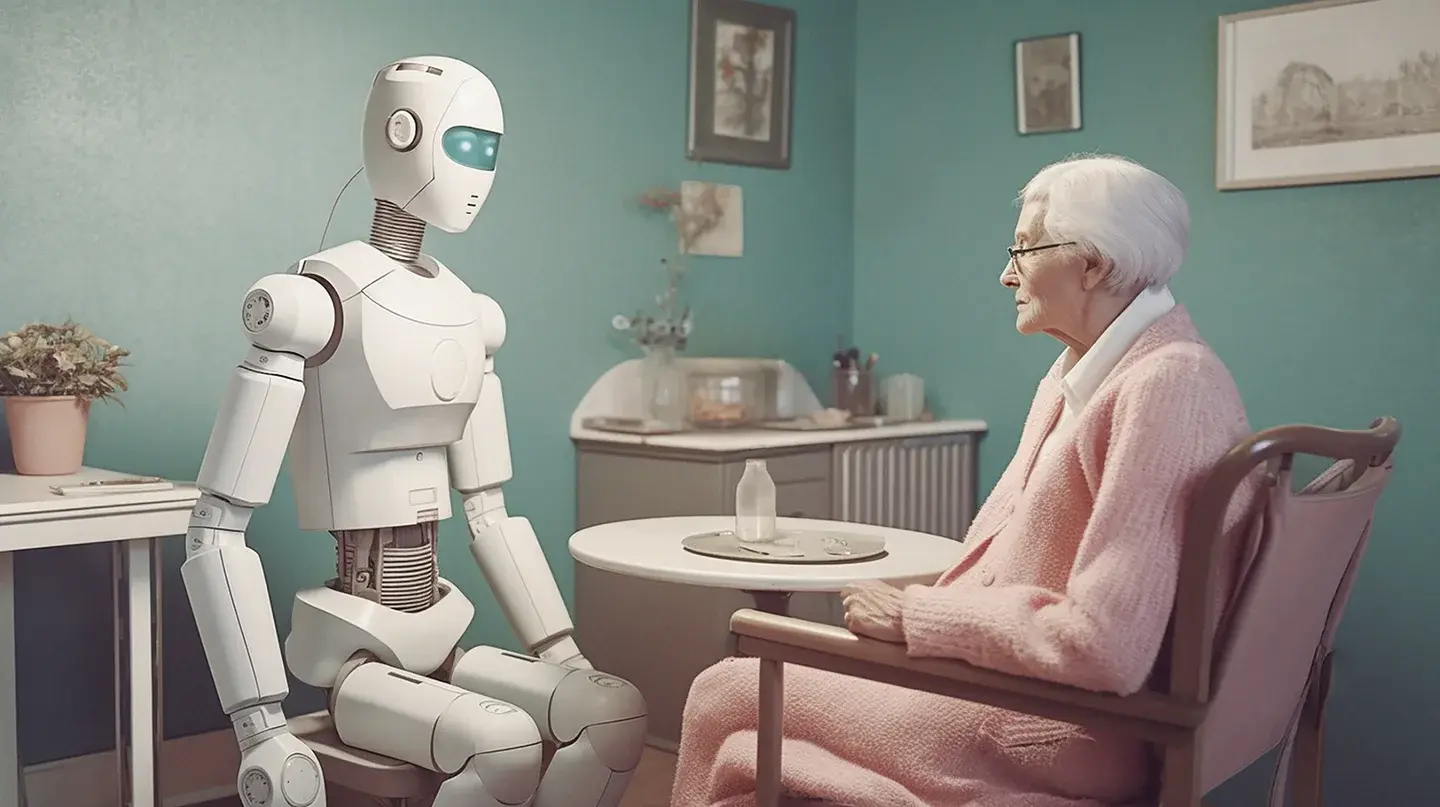

Иллюстрация, сгенерированная искусственным интеллектом, Дэн Сэлинджер

Если бы пациент знал, что его врач собирается сообщить ему плохую информацию во время предстоящего приема, он бы немедленно отменил встречу. Однако генеративные модели искусственного интеллекта (ИИ), такие как ChatGPT, часто "галлюцинируют", что на жаргоне технологической индустрии означает "выдумывают". Так зачем же кому-то использовать искусственный интеллект в медицинских целях?

Вот оптимистичный сценарий: Инструменты ИИ обучаются на проверенной медицинской литературе, как это уже делают некоторые разрабатываемые модели, а также сканируют истории болезни и данные смарт-часов. Затем, как и другие генеративные ИИ, они создают текст, фотографии и даже видео, персонализированные для каждого пользователя и достаточно точные, чтобы быть полезными. Антиутопическая версия: Правительства, страховые компании и предприниматели продвигают несовершенный ИИ, чтобы сократить расходы, в результате чего пациенты отчаянно нуждаются в медицинской помощи людей.

Уже сейчас легко представить, что все пойдет не так, тем более что ИИ уже обвиняли в том, что он извергает вредные советы в Интернете. В конце весны Национальная ассоциация по борьбе с расстройствами пищевого поведения временно отключила свой чат-бот после того, как один из пользователей заявил, что он поощряет нездоровые диетические привычки. Однако в США люди по-прежнему могут загружать приложения, использующие искусственный интеллект для оценки симптомов. А некоторые врачи, несмотря на существующие проблемы, пытаются использовать эту технологию для более внимательного общения с пациентами.

Удобный формат.