Джеффри Хинтон. Искусственный интеллект и этическая проблема Google

Разговоры об опасностях искусственного интеллекта, действительных или мнимых, приобрели лихорадочный характер, во многом вызванные растущим миром генеративных чат-ботов. При тщательном анализе критиков следует обратить внимание на их мотивы. Какую выгоду они получают, занимая ту или иную позицию? В случае с Джеффри Хинтоном, которого нескромно называют "крестным отцом ИИ", повышенное внимание должно быть более пристальным, чем в других случаях.

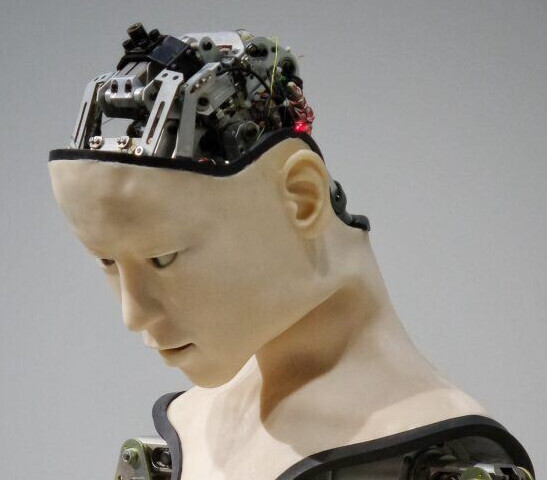

Хинтон является представителем "коннекционистской" школы мышления в ИИ, некогда дискредитировавшей себя области, которая предусматривает нейронные сети, имитирующие человеческий мозг и, в более широком смысле, человеческое поведение. Такая точка зрения расходится с "символистами", которые считают ИИ управляемым машиной, хранителем определенных символов и правил.

Джон Торнхилл, пишущий для Financial Times, отмечает рост Хинтона, а также других представителей племени коннекционистов: "По мере того, как компьютеры становились все мощнее, массивы данных увеличивались в размерах, а алгоритмы становились все более сложными, исследователи глубокого обучения, такие как Хинтон, смогли получить все более впечатляющие результаты, которые уже не могли игнорироваться основным сообществом ИИ".

Со временем системы глубокого обучения вошли в моду, и мир больших технологий стал стремиться к таким именам, как Хинтон. Он, как и его коллеги, стал получать абсурдные зарплаты на вершинах Google, Facebook****, Amazon и Microsoft. В Google Хинтон занимал должность вице-президента и научного сотрудника.

Уход Хинтона из Google, а точнее, его роль руководителя команды Google Brain, заставил закрутиться колесо спекуляций. Одна из версий гласила, что это произошло для того, чтобы он мог критиковать ту самую компанию, достижениям которой он помогал на протяжении многих лет. Это, конечно, было немного богато, учитывая роль самого Хинтона в продвижении генеративного ИИ. В 2012 году он впервые создал самообучающуюся нейронную сеть, способную с высокой точностью идентифицировать обычные объекты на фотографиях.

Время также представляет интерес. Чуть более месяца назад Институт будущего жизни опубликовал открытое письмо, в котором предупреждал об ужасных последствиях ИИ, помимо злодеяний OpenAI GPT-4 и других подобных систем. Был поставлен ряд вопросов: "Должны ли мы позволить машинам наводнить наши информационные каналы пропагандой и неправдой? Должны ли мы автоматизировать все виды работ, включая те, которые приносят удовлетворение? Должны ли мы развивать нечеловеческие разумы, которые в конечном итоге превзойдут, перехитрят, устареют и заменят нас? Должны ли мы рисковать потерей контроля над нашей цивилизацией?

Призывая к шестимесячной паузе в разработке таких масштабных проектов ИИ, письмо привлекло ряд имен, что несколько снижает ценность предупреждений; в конце концов, многие подписавшие письмо сыграли далеко не незначительную роль в создании автоматизации, устаревании и поощрении "потери контроля над нашей цивилизацией". Поэтому, когда такие люди, как Элон Маск и Стив Возняк, ставят свои подписи под проектом, призывающим сделать паузу в развитии технологий, детекторы бреда во всем мире должны сработать.

Те же принципы должны применяться и к Хинтону. Он явно ищет другие приоритеты и при этом занимается саморекламой. Это принимает форму мягкого осуждения той самой вещи, за создание которой он был ответственен. "Идея о том, что эта штука может стать умнее людей - несколько человек поверили в это. Но большинство людей думали, что это далеко не так. И я думал, что это не так. [...] Очевидно, я больше так не думаю". Казалось бы, ему лучше знать, чем большинству.

В Твиттере Хинтон пресек любые предположения о том, что он покидает Google на кислой ноте или что у него было намерение обрушиться на ее деятельность. "Сегодня в NYT Кейд Метц утверждает, что я ушел из Google, чтобы критиковать Google. На самом деле, я ушел, чтобы говорить об опасностях искусственного интеллекта, не задумываясь о том, как это влияет на Google. Google действовал очень ответственно".

Эта несколько странная форма рассуждений предполагает, что любая критика ИИ будет существовать независимо от тех компаний, которые разрабатывают такие проекты и получают от них прибыль, оставляя разработчиков - таких как Хинтон - защищенными от любых обвинений в соучастии. Тот факт, что он, похоже, не способен разработать критику ИИ или предложить нормативные рамки в самой компании Google, подрывает искренность этого шага.

Реагируя на уход своего давнего коллеги, Джефф Дин, главный научный сотрудник и глава Google DeepMind, также сообщил, что вода остается спокойной, к всеобщему удовлетворению. "Джефф совершил фундаментальные прорывы в области ИИ, и мы ценим его десятилетний вклад в Google. Будучи одной из первых компаний, опубликовавших Принципы ИИ, мы по-прежнему привержены ответственному подходу к ИИ. Мы постоянно учимся понимать возникающие риски и одновременно смело внедряем инновации".

Некоторые представители сообщества ИИ все же почувствовали, что происходит что-то другое. Компьютерный ученый Роман Ямпольский, отвечая на замечания Хинтона, уместно заметил, что забота о безопасности ИИ не является взаимоисключающей с исследованиями внутри организации - и не должна быть таковой. "Мы должны сделать нормальной заботу о безопасности ИИ без необходимости бросать работу в качестве исследователя ИИ".

У Google определенно есть то, что можно назвать проблемой этики, когда речь идет о разработке ИИ. Организация стремится закрывать внутренние дискуссии на эту тему. Маргарет Митчелл, ранее возглавлявшая команду Google по этическому ИИ, одним из основателей которой она стала в 2017 году, была уволена после проведения внутреннего расследования увольнения Тимнита Гебру, который был членом той же команды.

Гебру был уволен в декабре 2020 года после того, как стал соавтором работы, в которой оспаривались опасности, возникающие при использовании искусственного интеллекта, обученного и питающегося огромными объемами данных. И Гебру, и Митчелл также критически отзывались о явном недостатке разнообразия в этой области, которую последний назвал "морем пижонов".

Что касается философских дилемм самого Хинтона, то они далеки от изощренности и вряд ли потревожат его сон. Какую бы роль Франкенштейн ни сыграл в создании того самого монстра, о котором он теперь предупреждает, его сон вряд ли будет потревожен. "Я утешаю себя обычным оправданием: если бы я этого не сделал, это сделал бы кто-то другой", - объяснил Хинтон газете "Нью-Йорк таймс". "Трудно понять, как можно помешать плохим игрокам использовать его для плохих дел".

Источник: news.com